![]()

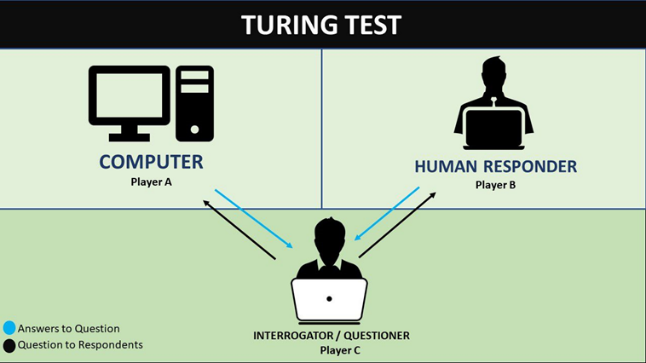

เว็บไซต์ TechRadar รายงานเมื่อ 23 เม.ย.68 ว่า ตามที่บทความวิจัยของมหาวิทยาลัยแคลิฟอร์เนีย แซนดีเอโก (UCSD) เกี่ยวกับการทดสอบแบบจำลองภาษาขนาดใหญ่ (LLMs) เช่น Chat GPT-4o GPT-4.5 จากบริษัท OpenAI และ LLaMa-3.1-405B จากบริษัท Meta ด้วยแบบทดสอบ Turing Test* เพื่อทดสอบว่า LLMs สามารถตอบคำถามได้เหมือนมนุษย์จนผู้ทดสอบไม่สามารถแยกแยะได้ว่ากำลังสนทนากับมนุษย์หรือคอมพิวเตอร์หรือไม่ โดยมีผู้เข้าร่วมทดสอบ 283 คน โดยให้มนุษย์และ LLMs ที่เป็นคู่สนทนาซึ่งต้องพยายามโน้มน้าวมนุษย์ผู้สอบถามให้เชื่อว่าพวกเขากำลังพูดคุยกับมนุษย์จริงๆ โดยการสนทนามีเวลาจำกัด 5 นาที

จากการทดสอบพบว่าการสั่ง AI ด้วยพร้อมต์ (Prompt) แบบสวมบทบาท (Persona) และไม่สวมบทบาท (No-Persona) มีความแตกต่างกันอย่างชัดเจนอย่างมีนัยสำคัญ โดย GPT-4.5 ที่ได้รับการพร้อมต์ให้สวมบทบาทถูกเชื่อว่าเป็นมนุษย์ถึง 73% จากการทดสอบทั้งหมด ซึ่งสูงกว่าผู้เข้ารับการทดสอบที่เป็นมนุษย์ ในทางตรงกันข้าม เมื่อนำการพร้อมต์บุคลิกเฉพาะออกไป ความสามารถในการหลอกผู้สอบถามก็ลดลงอย่างมาก โดยอัตราการชนะลดลงเหลือเพียง 36% ดังนั้นการกำหนดบุคลิกเฉพาะช่วยให้ AI ประสบความสำเร็จอย่างมากในการหลอกผู้ตั้งคำถามว่าพวกเขากำลังสนทนากับมนุษย์

อย่างไรก็ดี ความแตกต่างที่ชัดเจนนี้บ่งชี้ว่า AI ทำได้เพียง “สวมบทบาท” (Playing a part) แต่ไม่ได้มีสติสัมปชัญญะ (Conscious) หรือรับรู้ตัวเอง (Self-aware) อย่างแท้จริง หากปราศจากการกำหนดบุคลิกเฉพาะ โมเดล AI ก็เป็นเพียงระบบที่ทำนายคำถัดไป (Autocomplete) ทั่วไป อีกทั้งในขณะที่สนทนา AI ไม่รู้สึกวิตกกังวลก่อนที่จะพูด ไม่สนใจว่าได้หลอกผู้ตั้งคำถามสำเร็จหรือไม่ และไม่ภูมิใจในการผ่านการทดสอบ เพราะมันไม่รู้ว่าการทดสอบคืออะไร